技术整理sqoop

Sqoop的安装与部署

1/ 将sqoop解压 到usr下

2/ 配置sqoop下的conf目录下的env环境文件

先切换目录:cd /usr/sqoop/conf

编辑文件命令:gedit sqoop-env-template.sh

找到被注释的有关HADOOP的变量 2个

将前面注释的#号去掉

将等号后的值改为hadoop路径:=usr/hadoop

HBase路径用不到 就注释掉

Hive也可以不配置 Zookeeper也可以不配置

3/ 将mysql的jdbc的jar包 拷贝到sqoop/lib/下

4/ 在sqoop的bin目录下,有很多命令

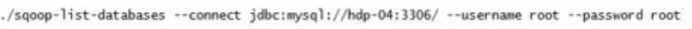

下面命令是测试连接mysql

(首先,保证mysql’有’密码,没设置密码的,自行百度,把mysql中的user表的Host列的localhost改为% 这样就给了外部机器访问权限

查询–>新建查询,输入sql语句刷新mysql

:flush privileges;

然后把mysql的my.ini文件加入

[mysqld]

bind-address=0.0.0.0

这段命令也是给所有连接权限) 重启mysql服务

返回数据库信息

返回库里的表的信息

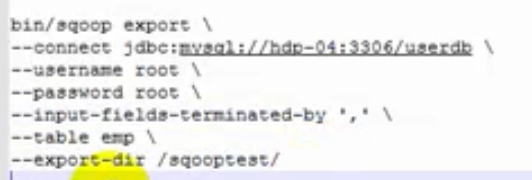

Hdfs导出到mysql

直接复制这段:./sqoop export --connect jdbc:mysql://172.16.2.2:3306/test --username root --password 1234 --input-fields-terminated-by “\t” --table abc --export-dir /flume/output/part-r-00000

注意!!!

–input-fields-terminated-by 分割命令后面必须是单字符!!!

mysql的列应该和hdfs的数据分割列相反

把连库串修改下

注:

input-fields-terminated-by ‘—’ 根据’—’分割字段

–export-dir 后面是hdfs里的数据块

目录 返回

首页